声明:本文来自于微信公众号 机器之心(ID:almosthuman2014),作者:机器之心,授权站长之家转载发布。

最近的一系列研究表明,纯解码器生成模型可以通过训练利用下一个 token 预测生成有用的表征,从而成功地生成多种模态(如音频、图像或状态 - 动作序列)的新序列,从文本、蛋白质、音频到图像,甚至是状态序列。

能够同时生成[]多种模态输出[]的多模态模型[]一般是通过某[]种形式的词汇[]扩展(将多模[]态表征转换为[]离散 token 并添加到模型[]的基本词汇表[]中)来实现的[],即在预训练[]阶段或在后期[]微调阶段进行[]跨模态对齐。[]

多模态预训练方法具有很强的性能优势(例如,一个模型可以原生理解多种模态),但也有缺点。例如,无法解决如何在预训练后添加新模态的问题,也缺乏灵活性,因为添加另一种模态需要从头开始训练一个新的模型,并进行超参数搜索,以获得模态之间的最佳训练数据混合比。因此,这种解决方案不适合小众模态,特别是 IMU、蛋白质序列等。

或者,将词汇[]扩展到另一种[]模态可以在一[]个从未见过该[]模态的模型上[]进行预训练后[]进行。只在文[]本模态下训练[]的解码器模型[]可以在上下文[]中遵循指令并[]从样本中学习[],通常是通过[]微调将另一种[]模态(如音频[]或图像功能)[]嫁接到现有的[]强大文本骨干[]上,以利用文[]本模态的可表[]达性和人类用[]户的可控性。[]这样做的缺点[]是骨干网络的[]文本到文本功[]能会被破坏,[]由此产生的模[]型只能执行其[]经过微调的跨[]模态任务。

总体来说,无[]论是预训练还[]是微调,都需[]要大量对齐的[]跨模态数据,[]因此这两种方[]法都不适用于[]没有足够数量[]以对齐多模态[]数据的模态。[]

Google DeepMind 近期提出了模块化设计的新型架构 Zipper,它由多个单模态预训练解码器模型组成。利用丰富的无监督单模态数据,Zipper 可以在单一模态中预训练强大的纯解码器模型,然后利用交叉注意力将多个这样的预训练解码器「压缩」在一起,并利用有限的跨模态数据进行微调,实现多模态生成能力。预训练的纯解码器模型可以在新的多模态组合中灵活地重复使用和再利用。

论文标题:Zipper: A Multi-Tower Decoder Architecture for Fusing Modalities

论文链接:https://arxiv.org/pdf/2405.18669

这是第一项研究灵活组合模态的工作,通过组合单独预训练的单模态解码器来实现多模态生成能力。

虽然 Zipper[] 架构可在多种[]模态和两种以[]上模态的骨干[]上通用,但这[]项工作的重点[]放在了仅融合[]两种骨干(语[]音和文本)的[]实验设置上。[]论文展示了 Zipper[] 在同时跨模态[]生成文本(自[]动语音识别([]ASR)任务[])和语音(文[]本到语音任务[](TTS))[]方面的强大能[]力。

仅使用部分文[]本 - 语音对齐数据[](低至原始数[]据的1%)进[]行的实验表明[],首先在无标[]记数据上对骨[]干进行单模态[]预训练,与使[]用词汇扩展方[]法进行微调相[]比,Zipp[]er 可以依赖更少[]的对齐数据,[]这为使用解码[]器 - 解码器架构融[]合模态提供了[]可能性,对于[]成对数据量有[]限的生成任务[]非常有用。

接下来,让我[]们看看论文细[]节。

模型

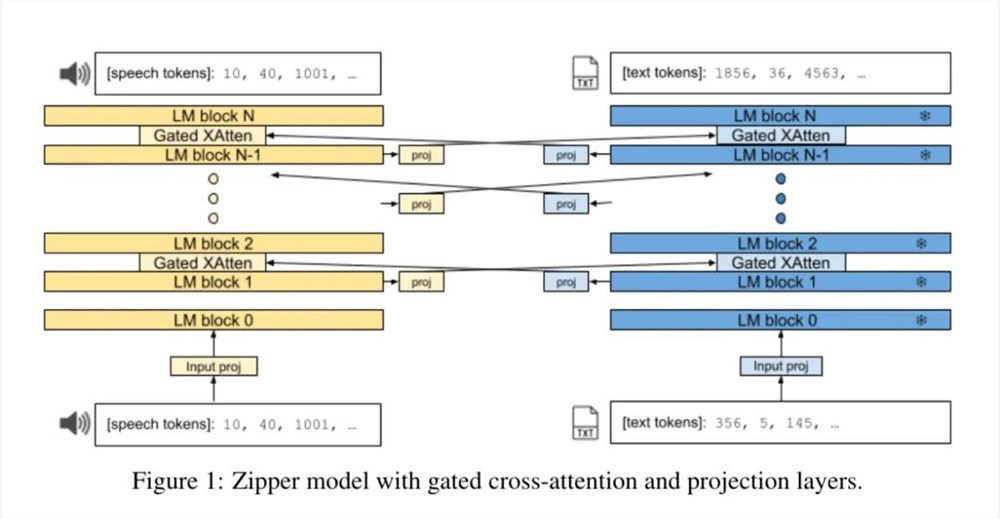

Zipper[] 架构由两个自[]回归解码器 tower([]或主干)组成[],它们通过门[]控交叉注意力[]层「压缩」在[]一起。每个骨[]干使用下一个[] token 预测功能分别[]对单个模态进[]行训练。

图1显示了 Zipper 架构的概览。与 CALM 类似,在解码器骨干之间的每 i 层都插入了交叉注意力层。在这些有规律交错的层中,一种模态的表征被交叉注意力到另一种模态中。这与 Flamingo [4] 编码器 - 解码器设置不同,后者只在一个 tower(编码器)的最后一层定期交叉注意力到另一个 tower(解码器)的各层。

在交叉注意力[]过程中,投影[]层被插入模态[]之间。从功能[]上讲,这可以[]均衡骨干之间[]的嵌入维度大[]小差异。从语[]义上讲,它还[]能实现从一种[]模态到另一种[]模态的表征转[]换,尤其是当[]一个或两个骨[]干被冻结时。[]此外,在每个[]骨干网的输入[]嵌入之后,还[]直接加入了一[]个非线性输入[]投影层,以便[]更好地调整输[]入的单模态表[]征,用于多模[]态任务。

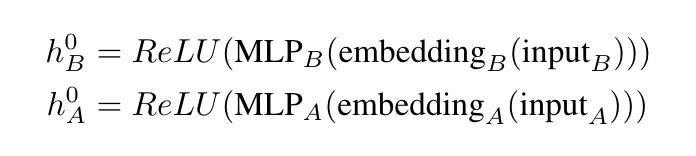

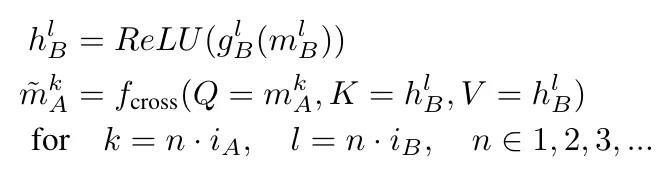

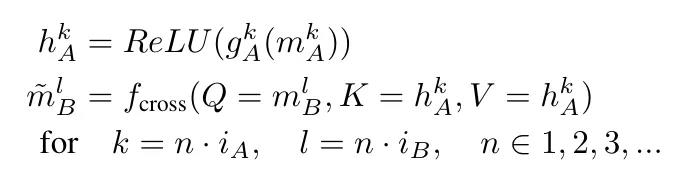

在第一个 Transformer 块之前(嵌入层之后),插入两个可学习的多层感知器(MLP)投影,然后对每个骨干进行 ReLU 转换:

这样做是为了[]让单模态表征[]更好地适应多[]模态设置。

让 i_A 和 i_B 分别代表 A 层交叉到 B 层和 B 层交叉到 A 层的间隔。将 k 层单模解码器 A 的隐藏表征法称为

,其中 d_A 是 transformer A 的隐藏维度;同样,将 l 层单模解码器 B 的隐藏表征法称为

,其中 d_B 是 transformer B 的相应隐藏维度。设 fcross (Q, K, V ) 是来自 [4] 的门控交叉注意力层,其后是前馈层,Q、K、V 分别是查询、键和值。让

和

分别代表 tower A 和 tower B 的线性前馈投[]影和全连接投[]影。

解码器 A 中第 k 层的新表征

。

具体如下:

同样,解码器 B 第 l 层的新表征

为:

最后,每个 tower 以一个 softma[]x 层(与同 tower 嵌入层共享)[]结束,以便利[]用下一个 token 预测任务将隐[]藏表征投射到[](特定模态 /tower[])token[] 词汇的概率分[]布中。

研究者将交叉[]注意力机制用[]于交错序列的[]自动回归训练[],具体做法是[]只交叉关注原[]始线性序列中[]当前位置之前[]的另一种模态[]的数据。

在解码过程中,输出模态的序列是指定的(例如,[语音]、[文本]、[文本、语音])。模型以序列中的第一种模态生成输出,直到遇到特殊的句末 token,这时才会切换到序列中的下一种模态。该过程一直持续到序列中的所有模态都被解码为止。虽然可以扩展模型自动选择输出生成的模态,但这一设置的通用化还需要后续的工作。

实验

虽然 Zipper[] 可以扩展到任[]意数量的模态[],研究者率先[]评估了语音到[]文本生成和文[]本到语音(T[]TS)生成的[]自动语音识别[](ASR)。[]

值得注意的是[],虽然对 TTS 系统(合成语[]音)的标准评[]估依赖于人类[]反馈(平均意[]见分数),可[]以捕捉到语音[]的许多整体方[]面(如文本保[]真度和声音质[]量等),但这[]里的 TTS 评估只希望捕[]捉到架构选择[]对语义 token 建模和预测能[]力的影响。

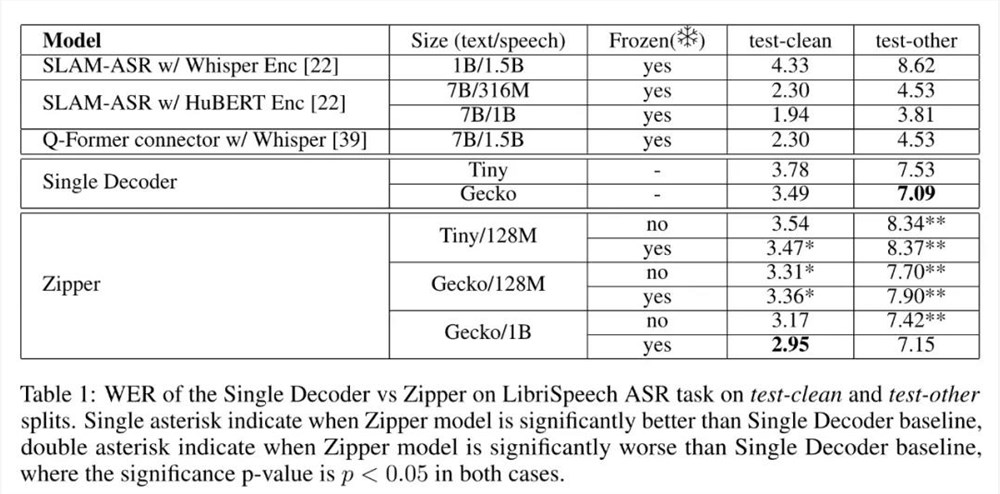

表1列出了 ASR 任务的测试结果:

将 Zipper[] 与扩展词汇量[]的单解码器基[]线进行比较时[],可以发现 Zipper[] 在 test-c[]lean 子集上的性能[]略好,而在噪[]音较高的语音[] test-o[]ther 子集上的性能[]则略有下降,[]总体性能相当[]接近。

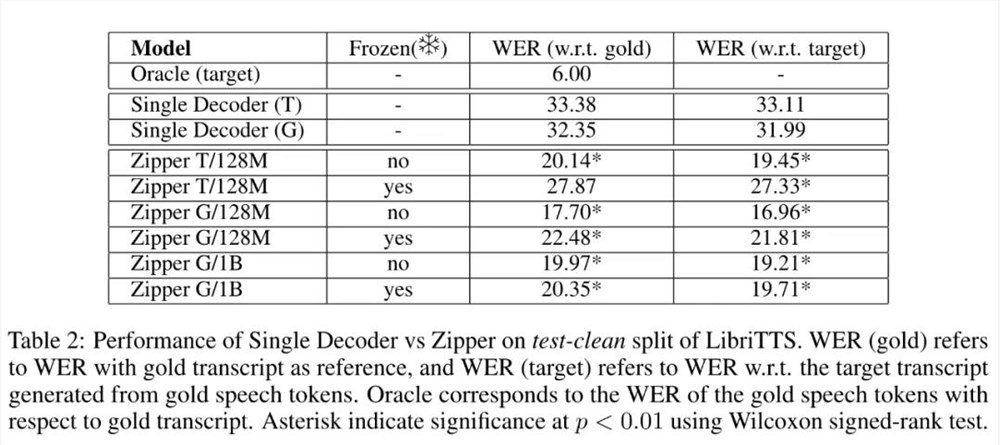

表2列出了在 LibriTTS 数据集的 test-clean 分割上进行 TTS 任务的结果。

可以看出,Z[]ipper 模型明显优于[]单解码器模型[],Zippe[]r S/128M[] unfroz[]en model 模型提高了1[]3个 WER 点(相对误差[]减少40%)[],Zippe[]r L/1B unfroz[]en model 模型提高了1[]2个 WER 点(相对误差[]减少38%)[]。

研究者还观察[]到,与使用冻[]结骨干网络相[]比,在训练过[]程中解冻语音[]骨干网络可持[]续改善所有尺[]寸 Zipper[] 模型的性能,[]这验证了直觉[] —— 微调语音骨干[]网络的参数比[]仅依赖交叉注[]意力产生的模[]态对齐效果更[]好。

更多研究细节,可参考原论文。

评论区

提示:本文章评论功能已关闭