要点:

本文提出了一种基于预训练的图像扩散模型的视频编辑方法,实现文本引导的编辑,无需训练或微调,可推广到广泛编辑领域。

通过自注意力特征注入,该方法在每个扩散步骤中注入前一帧的特征,以保持外观的一致性,解决了视频编辑中的外观变化问题。

引入了潜在更新机制,通过能量函数提高一致性,增强了算法的时间稳定性,减少了时间闪烁的影响。

11月29日 消息:Pix2Video是一项基于预训练的图像扩散模型的视频编辑研究,致力于实现文本引导的编辑,无需繁琐的训练或微调。该方法通过自注意力特征注入,在每个扩散步骤中注入前一帧的特征,以确保编辑后的视频外观连贯一致,解决了编辑过程中可能出现的外观变化问题。

此外,为提高算法的时间稳定性,引入了潜在更新机制,通过能量函数增强一致性,有效减少了时间闪烁的影响。

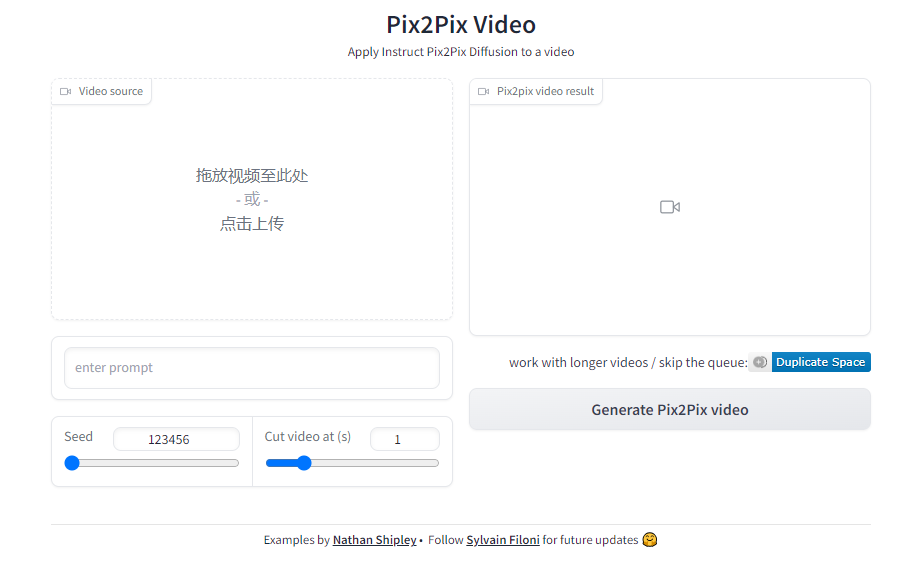

项目地址:h[]ttps:/[]/huggi[]ngface[].co/sp[]aces/f[]ffilon[]i/Pix2[]Pix-Vi[]deo

大规模图像生[]成扩散模型在[]静态图像生成[]方面表现出色[],但在处理视[]频编辑时面临[]挑战。为了应[]对这一挑战,[]Pix2Vi[]deo采用了[]深度条件稳定[]扩散模型,通[]过对每帧进行[]深度预测,并[]将其作为模型[]的额外输入,[]以捕捉运动动[]态和几何变化[]。

自注意力特征[]注入是该方法[]的关键步骤,[]通过在解码器[]层执行特征注[]入,确保在保[]持外观一致性[]的同时避免高[]频结构变化。[]此外,为提高[]时间稳定性,[]潜在更新机制[]通过额外的指[]导来更新隐变[]量,通过能量[]函数增强一致[]性,降低了时[]间闪烁的影响[]。

Pix2Video的实验证明了其方法的有效性,并与四种不同的先前工作进行了比较,证明了文本引导的视频编辑是可能的,无需复杂的预处理或视频个性化微调。该研究为实时互动视频编辑领域提供了一种创新方法,具有潜在的应用前景。

评论区

提示:本文章评论功能已关闭