5月16日 消息:UIUC与BigCode组织的研究者们最近发布了StarCoder2-15B-Instruct代码大模型,这一创新成果在代码生成任务方面取得了显著突破。这款模型成功超越了CodeLlama-70B-Instruct,登上了代码生成性能榜单之巅。

StarCoder2-15B-Instruct的独特之处在于其纯自对齐策略,整个训练流程公开透明,且完全自主可控。通过自我生成数千个指令-响应对,直接对StarCoder-15B基座模型进行微调,无需依赖昂贵的人工标注数据,也无需从商业大模型中获取数据,避免了潜在的版权问题。

在Human[]Eval测试[]中,Star[]Coder2[]-15B-I[]nstruc[]t以72.6[]%的Pass[]@1成绩脱颖[]而出,较Co[]deLlam[]a-70B-[]Instru[]ct的72.[]0%有所提升[]。在Live[]CodeBe[]nch数据集[]的评估中,这[]一自对齐模型[]的表现甚至超[]越了基于GP[]T-4生成数[]据训练的同类[]模型,证明了[]通过自身数据[]训练的大模型[]同样能够有效[]地学习如何与[]人类偏好对齐[]。

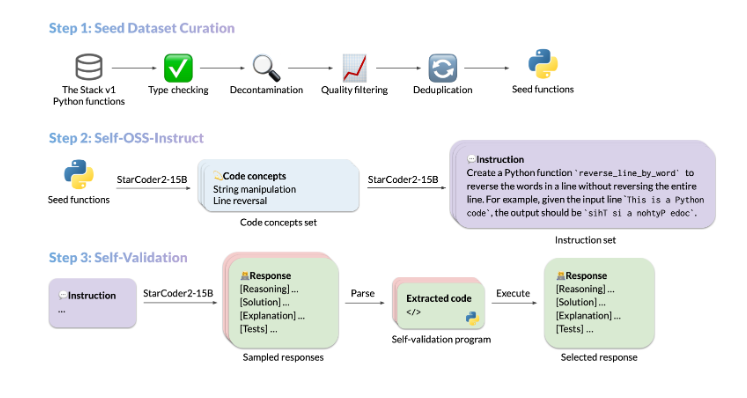

StarCoder2-15B-Instruct的数据生成流程主要包括种子代码片段的采集、多样化指令的生成和高质量响应的生成三个核心步骤。种子代码片段的采集是通过从开源代码片段中选取高质量、多样化的种子函数开始的。然后,基于这些种子函数的不同编程概念,StarCoder2-15B-Instruct能够创建出多样化且真实的代码指令。最后,通过自我验证的方式确保生成的响应是准确且高质量的。

StarCo[]der2-1[]5B-Ins[]truct在[]备受瞩目的E[]valPlu[]s基准测试中[]表现出色,超[]越了规模更大[]的Grok-[]1Comma[]nd-R+和[]DBRX,并[]与Snowf[]lake Arctic[]480B和M[]ixtral[]-8x22B[]-Instr[]uct等业界[]翘楚性能相当[]。此外,在L[]iveCod[]eBench[]和DS-10[]00等评估平[]台上也展现出[]了强大的实力[]。

该项目的成功[]实施得到了美[]国东北大学A[]rjun Guha课题[]组、加州大学[]伯克利分校、[]Servic[]eNow和H[]ugging[] Face等机[]构的鼎力支持[]。

StarCo[]der2-1[]5B-Ins[]truct-[]v0.1的发[]布标志着研究[]者们在代码模[]型自我调优领[]域迈出了重要[]一步。这款模[]型的成功实践[]展示了通过自[]我调优同样能[]够构建出性能[]卓越的代码模[]型。同时,该[]模型的开源数[]据集和训练流[]程为未来该领[]域的研究和发[]展奠定了坚实[]的基础。

模型地址:https://huggingface.co/bigcode/starcoder2-15b-instruct-v0.1

评论区

提示:本文章评论功能已关闭