站长之家(ChinaZ.com) 5月20日 消息:Google DeepMind 发布了一份长达150页的技术报告,详细介绍了 Gemini1.5Pro 和 Gemini1.5Flash 两个模型的性能特点和架构以及这个多模态大型模型的最新进展。

Gemini[]1.5于今年[]2月上线,通[]过工程优化、[]MoE架构等[]策略显著提升[]了性能和速度[]。该模型具有[]更长的上下文[]理解能力、更[]强的推理能力[],能够处理跨[]模态内容。

报告中提到了两个新型号:

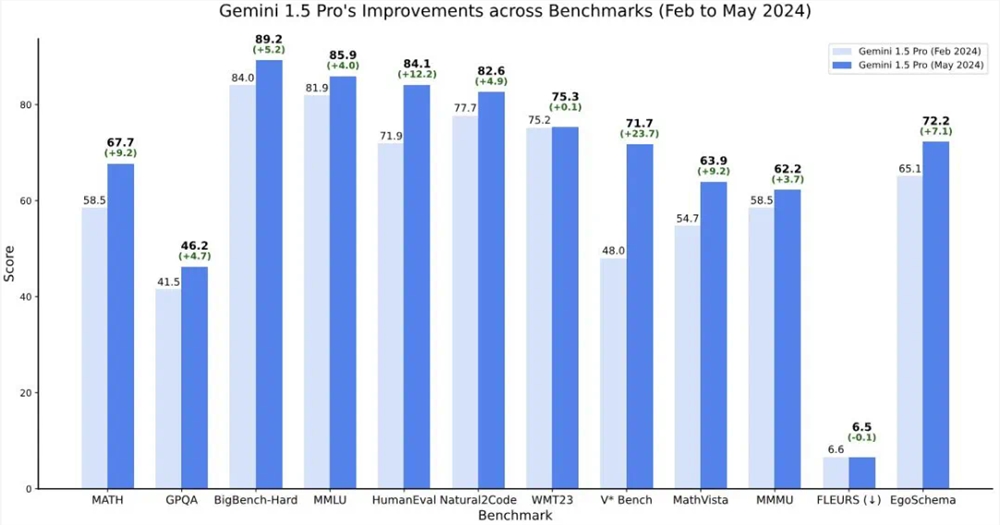

Gemini1.5Pro:在多个功能和基准测试中超越了2月份的版本。

Gemini1.5Flash:轻量级变体,旨在提高效率,性能损失极小。

Gemini1.5Flash是一个Transformer解码器模型,拥有超过2M的上下文和多模态功能,优化了张量处理单元(TPU)的使用,并减少了模型服务延迟。它能够并行计算注意力和前馈分量,使用高阶预处理方法提高训练质量。

报告还评估了[]Gemini[]1.5在处理[]英语、中文、[]日语和法语查[]询时,每个输[]出字符的平均[]时间。结果显[]示,Gemi[]ni1.5F[]lash在所[]有测试语言中[]实现了最快的[]生成速度。

此外,Gemini1.5在跨模态长上下文检索任务上实现了近乎完美的召回,提高了长文档问答、长视频问答和长上下文自动语音识别的最佳水平,并在一系列广泛的基准测试中匹配或超越了Gemini1.0Ultra的性能。

Gemini[]1.5Pro[]在5月份的版[]本在多个推理[]、编码、视觉[]和视频基准测[]试中进行了改[]进,而音频和[]翻译性能保持[]不变。

报告还介绍了[]Gemini[]1.5Pro[]数学增强版本[]的性能,它在[]Hendry[]ck的MAT[]H基准测试中[]取得了91.[]1%的突破性[]性能,解决了[]此前模型无法[]解决的亚太数[]学奥林匹克题[]目。

最后,报告强[]调了Gemi[]ni1.5在[]现实世界的应[]用潜力,展示[]了它与专业人[]士合作完成任[]务的能力,在[]10个不同的[]工作类别中可[]节省26-7[]5%的时间。[]此外,该模型[]还能学会将英[]语翻译成Ka[]lamang[],一种只有不[]到200人使[]用的语言,与[]人类学习者的[]水平相当。

Gemini1.5的技术报告展示了谷歌在大型多模态模型领域的最新进展,其性能的提升和应用潜力为未来的AI技术发展提供了新的方向。

详细报告:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

评论区

提示:本文章评论功能已关闭