声明:本文来自于微信公众号 量子位(ID:QbitAI),作者:量子位,授权站长之家转载发布。

还记得黑客帝国经典的子弹时间吗?

IDEA研究院最新检测模型T-Rex2,可以齐刷刷给全部识别出来~

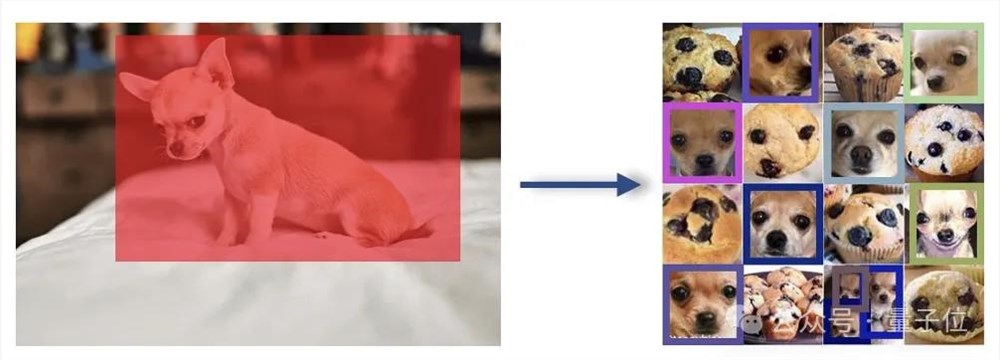

而面对难倒一众大模型「吉娃娃or松饼」的难题,它只需被投喂一张吉娃娃的照片,就能瞬间迎刃而解。

此前,也是同[]样的团队,推[]出了基于视觉[]提示的检测模[]型T-Rex[]。

如今,他们将[]视觉和文本提[]示融合,相互[]弥补各自的缺[]陷,实现了更[]强的目标检测[]能力。

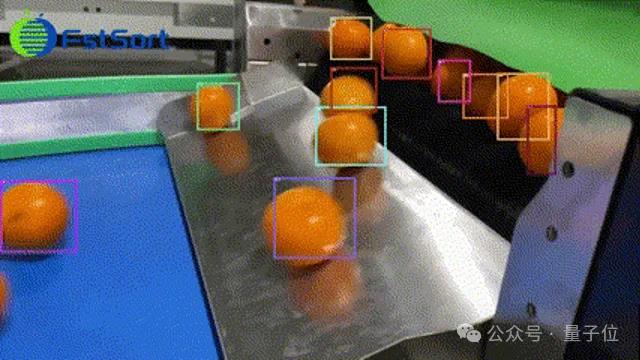

并且与多目标跟踪模型结合后,各种视频检测任务也不在话下。

来看新研究到底说了什么。

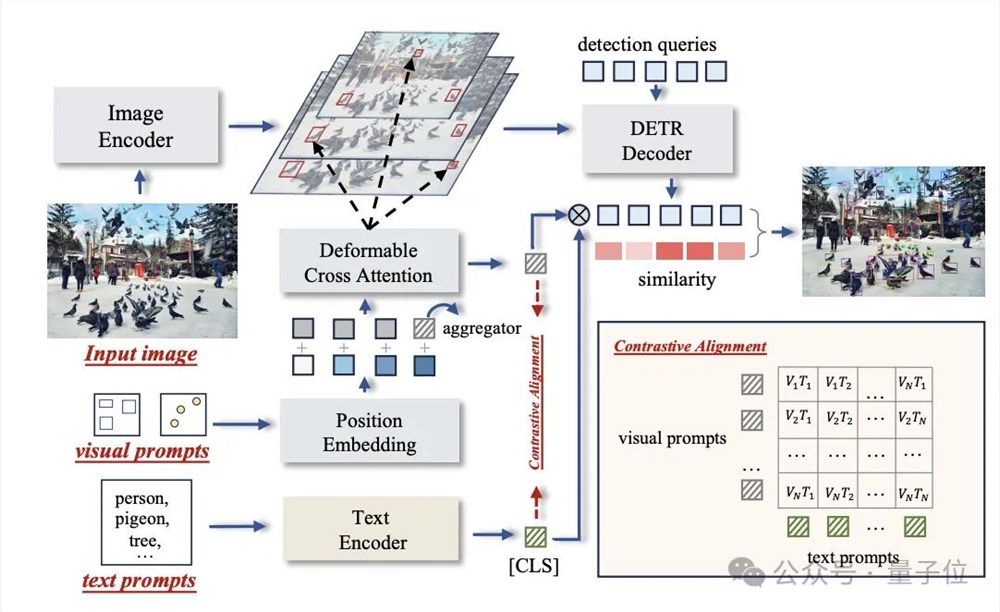

打通文本和视觉提示

在开集目标检测领域,尽管文本提示受到一定的青睐,但也存在一定的局限性。

比如长尾数据短缺。稀有或者全新的物体类别的数据稀缺可能会削弱其学习效率。还有描述上的局限性,对于一些难以用语言描绘的对象,因受限于无法精确描述,也会削弱效果。

而视觉提示提[]供了更直观且[]直接的对象表[]示方法,但在[]捕捉常见对象[]的概念时效果[]就会很差。

T-Rex2通过对比学习在单个模型中整合两种提示,因此接受多种格式的输入,包括文本提示、视觉提示以及两者的组合。

在不同场景中[],它可以通过[]在两种提示方[]式之间切换来[]处理。

因此,它大致[]有三种工作模[]式:

文本提示模式、交互式视觉提示模式、通用视觉提示模式。

以通用视觉提[]示模式为例,[]用户可以通过[]向模型提供任[]意数量的示例[]图片,来自定[]义特定对象的[]视觉嵌入,然[]后使用这个嵌[]入来检测任意[]图像中的对象[]。

也就是不需要[]用户与模型直[]接互动,就能[]完成检测任务[]。

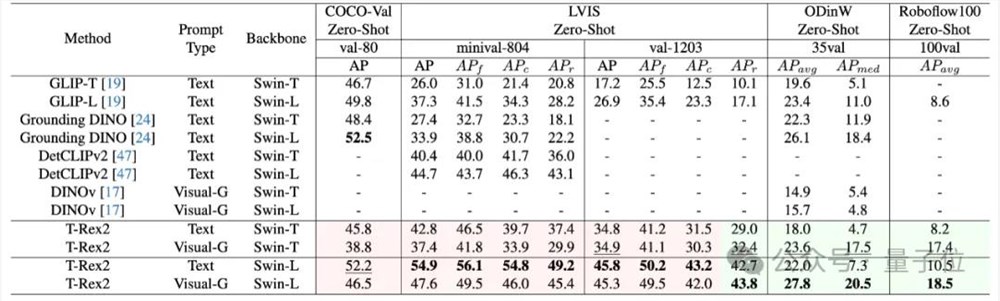

最终在在四个学术基准测试集 COCO, LVIS, ODinW, 和Roboflow100上取得了 Zero-Shot SOTA的性能。

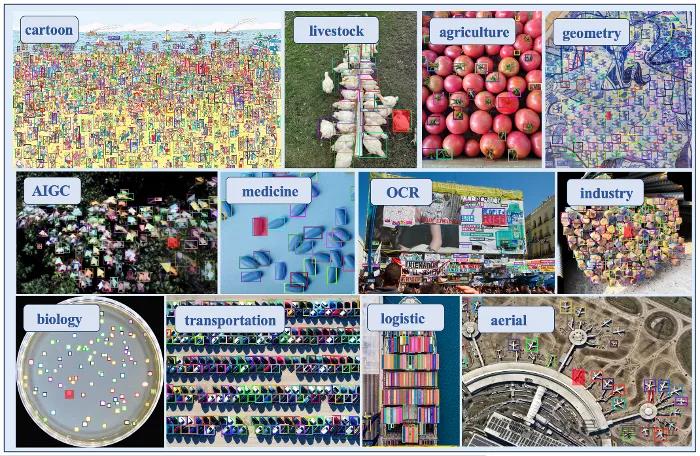

开箱即用诸多领域

无需重新训练或微调,T-Rex2即可检测模型在训练阶段从未见过的物体。

该模型不仅可应用于包括计数在内的所有检测类任务,还为智能交互标注领域提供新的解决方案。

除此之外,结合现有的多目标跟踪模型( 如ByteTrack ),T-Rex2还可用于视频检测任务。

事实上,这种[]跨图检测能力[],让目标检测[]技术在生产生[]活中可以真正[]开始广泛应用[]。

比如工业生产[]流水线器件检[]测,交通航运[]领域的船舶、[]飞机检测,农[]业领域的农作[]物、果蔬检测[],生物医学领[]域的细胞、组[]织检测,物流[]领域的货物检[]测,环境领域[]的野生动物监[]测等。

现在,T-R[]ex2让通用[]物体检测又迈[]出了新的一步[]。

试玩链接:

https:[]//deep[]datasp[]ace.co[]m/play[]ground[]/ivp

T-Rex2[]API:ht[]tps://[]github[].com/I[]DEA-Re[]search[]/T-Rex[]

论文链接:

https:[]//arxi[]v.org/[]abs/24[]03.146[]10

—完—

评论区

提示:本文章评论功能已关闭