声明:本文来自于微信公众号 机器之心(ID:almosthuman2014),作者:机器之心,授权站长之家转载发布。

没想到,自2012年 AlexNet 开启的深度学习革命已经过去了12年。

而如今,我们[]也进入了大模[]型的时代。

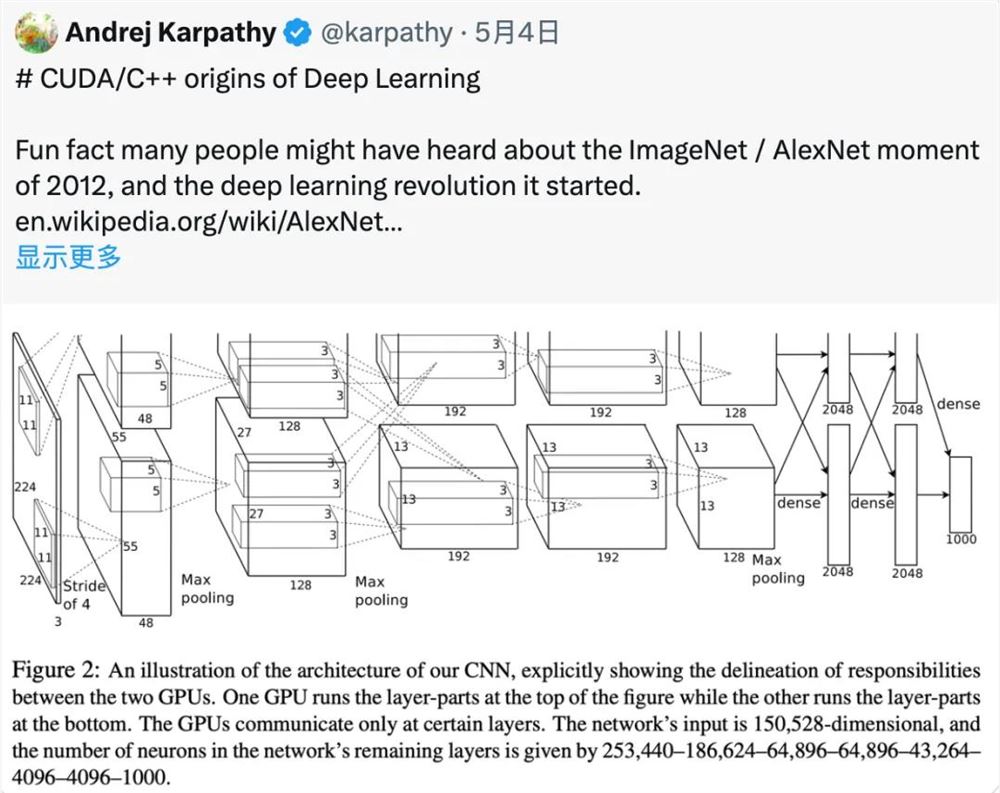

近日,知名 AI 研究科学家 Andrej Karpathy 的一条帖子,让参与这波深度学习变革的许多大佬们陷入了回忆杀。从图灵奖得主 Yann LeCun 到 GAN 之父 Ian Goodfellow,纷纷忆往昔。

到目前为止,该帖子已经有63万 + 的浏览量。

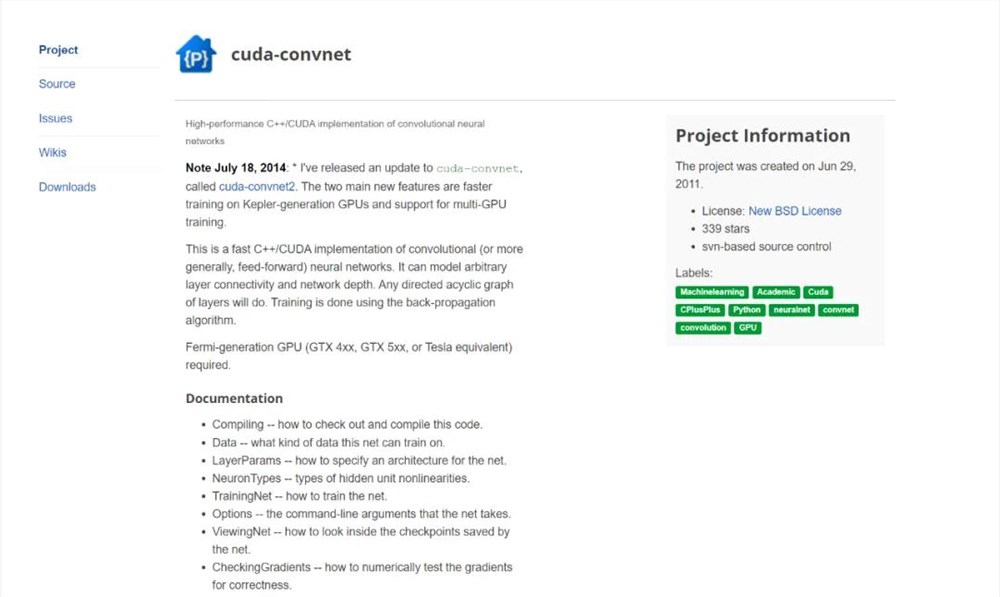

在帖子中,Karpathy 提到:有一个有趣的事实是,很多人可能听说过2012年 ImageNet/AlexNet 的时刻,以及它开启的深度学习革命。不过,可能很少有人知道,支持这次竞赛获胜作品的代码是由 Alex Krizhevsky 从头开始,用 CUDA/C++ 手工编写的。这个代码仓库叫做 cuda-convnet, 当时托管在 Google Code 上:

https:[]//code[].googl[]e.com/[]archiv[]e/p/cu[]da-con[]vnet/

Karpathy 想着 Google Code 是不是已经关闭了 (?),但他在 GitHub 上找到了一些其他开发者基于原始代码创建的新版本,比如:

https:[]//gith[]ub.com[]/ulric[]hstern[]/cuda-[]convne[]t

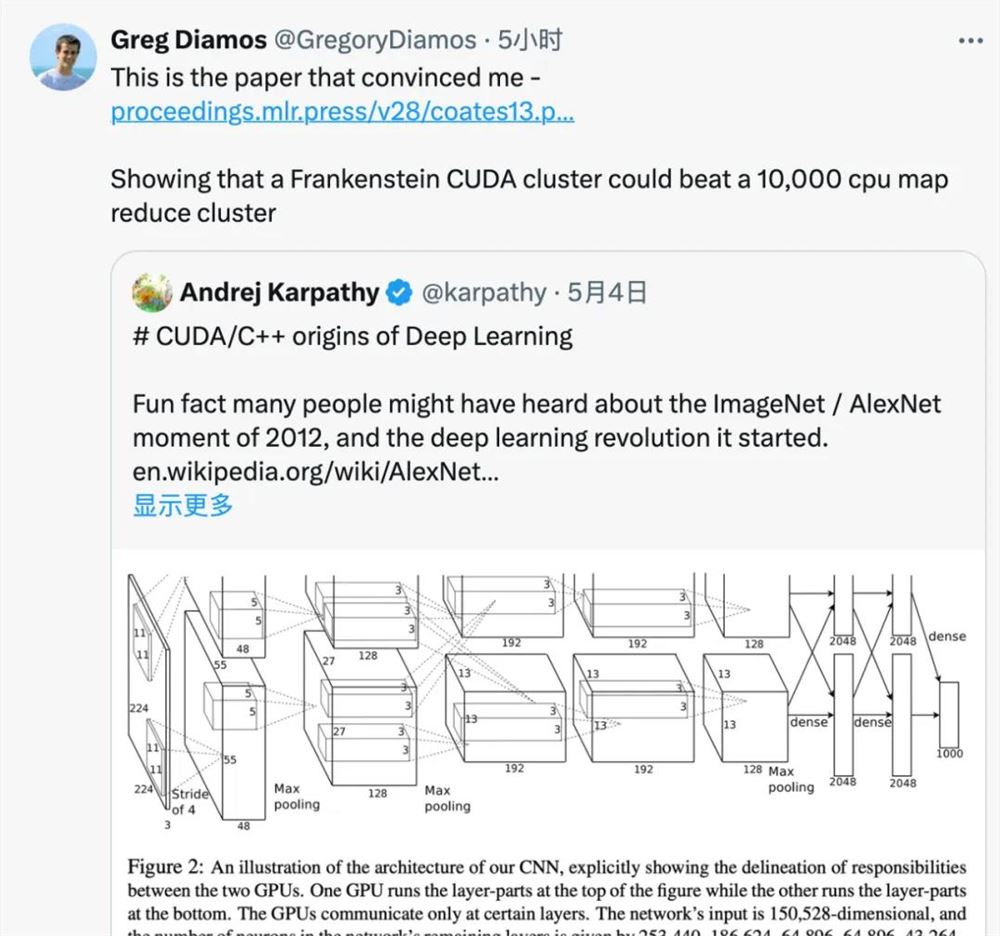

“AlexNet 是最早将 CUDA 用于深度学习的著名例子之一。”Karpathy 回忆说,正是因为使用了 CUDA 和 GPU,AlexNet 才能处理如此大规模的数据 (ImageNet),并在图像识别任务上取得如此出色的表现。“AlexNet 不仅仅是简单地用了 GPU,还是一个多 GPU 系统。比如 AlexNet 使用了一种叫做模型并行的技术,将卷积运算分成两部分,分别运行在两个 GPU 上。”

Karpat[]hy 提醒大家,你[]要知道那可是[]2012年啊[]!“在201[]2年 (大约12年[]前),大多数[]深度学习研究[]都是在 Matlab[] 中进行,跑在[] CPU 上,在玩具级[]别的数据集上[]不断迭代各种[]学习算法、网[]络架构和优化[]思路。” 他写道。但 AlexNe[]t 的作者 Alex、I[]lya 和 Geoff 却做了一件与[]当时的主流研[]究风格完全不[]同的事情 ——“不再纠[]结于算法细节[],只需要拿一[]个相对标准的[]卷积神经网络[] (ConvN[]et),把它[]做得非常大,[]在一个大规模[]的数据集 (Image[]Net) 上训练它,然[]后用 CUDA/C[]++ 把整个东西实[]现出来。”

Alex Krizhe[]vsky 直接使用 CUDA 和 C++ 编写了所有的[]代码,包括卷[]积、池化等深[]度学习中的基[]本操作。这种[]做法非常创新[]也很有挑战性[],需要程序员[]对算法、硬件[]架构、编程语[]言等有深入理[]解。

从底层开始的编程方式复杂而繁琐,但可以最大限度地优化性能,充分发挥硬件计算能力,也正是这种回归根本的做法为深度学习注入了一股强大动力,构成深度学习历史上的转折点。

有意思的是,这一段描述勾起不少人的回忆,大家纷纷考古2012年之前自己使用什么工具实现深度学习项目。纽约大学计算机科学教授 Alfredo Canziani 当时用的是 Torch,“从未听说有人使用 Matlab 进行深度学习研究......” 。

对此 Yann lecun 表示同意,2012年大多数重要的深度学习都是用 Torch 和 Theano 完成的。

Karpathy 有不同看法,他接话说,大多数项目都是在用 Matlab ,自己从未使用过 Theano,2013-2014年使用过 Torch。

一些网友也透露 Hinton 也是用 Matlab。

看来,当时使用 Matlab 的并不少:

知名的 GAN 之父 Ian Goodfellow 也现身说法,表示当时 Yoshua 的实验室全用 Theano,还说自己在 ImageNet 发布之前,曾为 Alex 的 cuda-convnet 编写了 Theano 捆绑包。

谷歌 DeepMind 主管 Douglas Eck 现身说自己没用过 Matlab,而是 C++,然后转向了 Python/Theano。

纽约大学教授 Kyunghyun Cho 表示,2010年,他还在大西洋彼岸,当时使用的是 Hannes SChulz 等人做的 CUV 库,帮他从 Matlab 转向了 python。

Lamini 的联合创始人 Gregory Diamos 表示,说服他的论文是吴恩达等人的论文《Deep learning with COTS HPC systems》。

论文表明 Frankenstein CUDA 集群可以击败10,000个 CPU 组成的 MapReduce 集群。

论文链接:h[]ttps:/[]/proce[]edings[].mlr.p[]ress/v[]28/coa[]tes13.[]pdf

不过,Ale[]xNet 的巨大成功并[]非一个孤立的[]事件,而是当[]时整个领域发[]展趋势的一个[]缩影。一些研[]究人员已经意[]识到深度学习[]需要更大的规[]模和更强的计[]算能力,GP[]U 是一个很有前[]景的方向。K[]arpath[]y 写道,“当然[],在 AlexNe[]t 出现之前,深[]度学习领域已[]经有了一些向[]规模化方向发[]展的迹象。例[]如,Matl[]ab 已经开始初步[]支持 GPU。斯坦[]福大学吴恩达[]实验室的很多[]工作都在朝着[]使用 GPU 进行大规模深[]度学习的方向[]发展。还有一[]些其他的并行[]努力。”

考古结束时,[]Karpat[]hy 感慨道 “在编写 C/C++ 代码和 CUDA kernel[] 时,有一种有[]趣的感觉,觉[]得自己仿佛回[]到了 AlexNe[]t 的时代,回到[]了 cuda-c[]onvnet[] 的时代。”

当下这种 "back to the basics" 的做法与当年 AlexNet 的做法有着异曲同工 ——AlexNet 的作者从 Matlab 转向 CUDA/C++,是为了追求更高的性能和更大的规模。虽然现在有了高级框架,但在它们无法轻松实现极致性能时,仍然需要回到最底层,亲自编写 CUDA/C++ 代码。

评论区

提示:本文章评论功能已关闭